新着動画

おすすめの記事

経済

JTA

World News insights

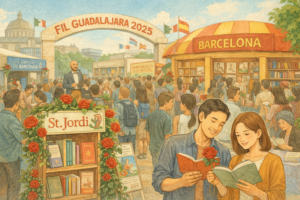

世界のブックフェアー

文芸

科学技術

月刊・翻訳の世界

リーガル